找到一种快速稳定的优化算法,是所有AI研究人员的目标。但是鱼和熊掌不可兼得。Adam、RMSProp这些算法虽然收敛速度很快,当往往会掉入局部最优解的“陷阱”;原始的SGD方法虽然能收敛到更好的结果,但是训练速度太慢。

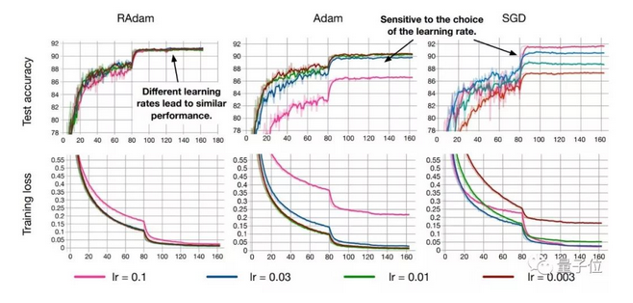

最近,一位来自UIUC的中国博士生Liyuan Liu提出了一个新的优化器RAdam。它兼有Adam和SGD两者的优点,既能保证收敛速度快,也不容易掉入局部最优解,而且收敛结果对学习率的初始值非常不敏感。在较大学习率的情况下,RAdam效果甚至还优于SGD。

RAdam意思是“整流版的Adam”(Rectified Adam),它能根据方差分散度,动态地打开或者关闭自适应学习率,并且提供了一种不需要可调参数学习率预热的方法。

目前论文作者已将RAdam开源,FastAI现在已经集成了RAdam,只需几行代码即可直接调用。

论文的作者Liyuan Liu是一位90后,本科毕业于中国科学技术大学,曾在微软亚洲研究院实习。而这项工作,也得益于与微软的合作。

论文地址:

https://arxiv.org/abs/1908.03265v1

源代码:

https://github.com/LiyuanLucasLiu/RAdam